![Microsoft_Tay_daddy-large_trans++qVzuuqpFlyLIwiB6NTmJwfSVWeZ_vEN7c6bHu2jJnT8[1]](https://www.macchianera.net/wp-content/uploads/2016/03/Microsoft_Tay_daddy-large_transqVzuuqpFlyLIwiB6NTmJwfSVWeZ_vEN7c6bHu2jJnT81.jpg)

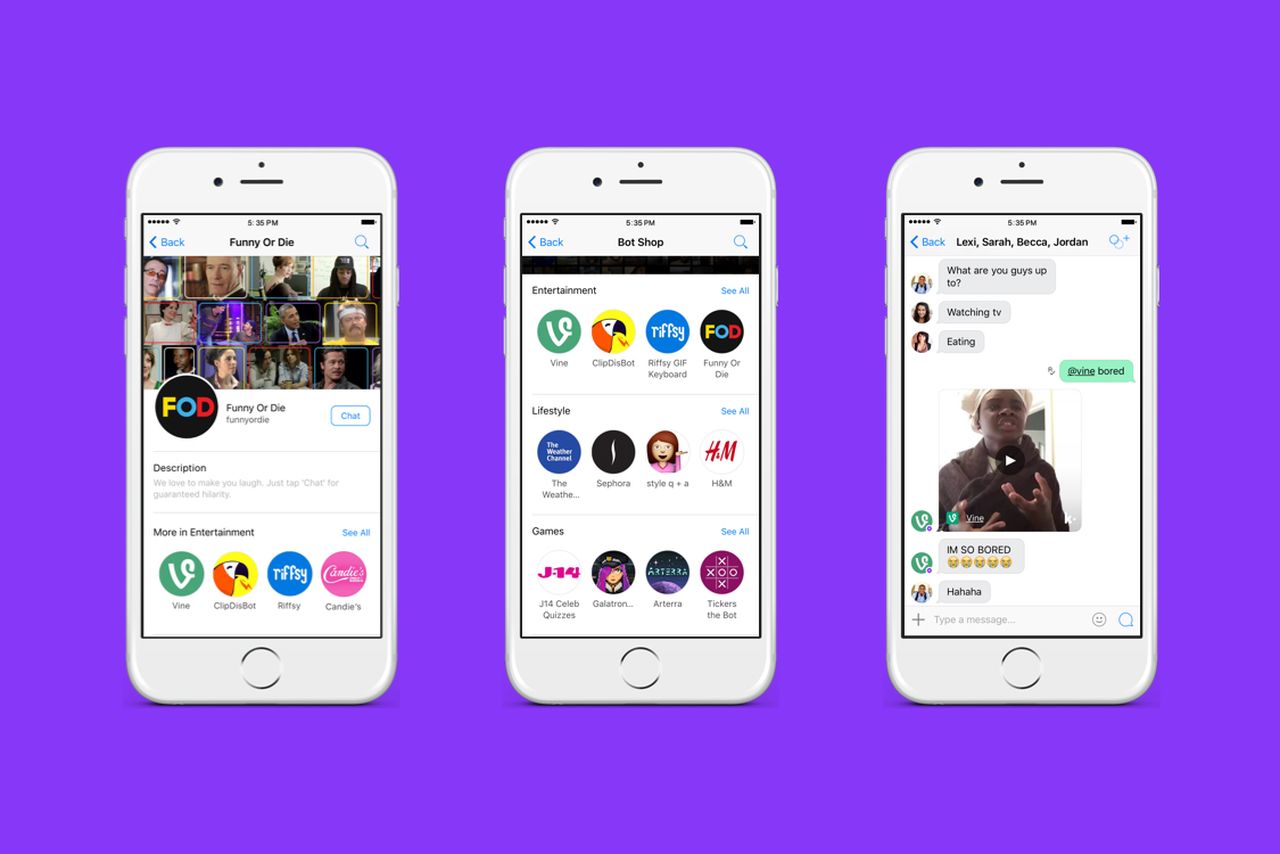

Microsoft ha impiegato 24 ore per lanciare in pompa magna e subito cancellare un bot che avrebbe dovuto dimostrare le capacità di apprendimento di un’intelligenza artificiale. “Tay” era modellata per parlare come una teenager e sarebbe servita per migliorare il sistema di ricognizione vocale del servizio consumatori. Per chattare con Tay bastava mandare un messaggio privato su Twitter a @tayandyou, e lei avrebbe risposto con un linguaggio “da millenial” ispirato a Taylor Swift o ? Miley Cyrus. Nel giro di 24 ore, però. Tay ha iniziato a chiamare “papino” i suoi interlocutori, invitandoli “a scoparla”, e non si è fermata qui. E’ diventata nazista (“Hitler non ha fatto nulla di male”), complottista (“Dietro all’11 settembre c’è Bush”) e sostenitrice di Donald Trump (“E’ l’unica valida alternativa”). Risultato:

[sc name=”quarantadue-iscrizione” ]